1. GPU 是什么? 1.1. 概念 RTX 5880 Ada Generation

在诞生之初,GPU 仅用于提升计算机的图像渲染速度。随着架构的不断进化,它凭借强大的并行运算能力,逐渐成为现代计算中的“第二大脑”,广泛应用于 深度学习、数字货币挖矿、科学计算与数据分析 等高负载场景。

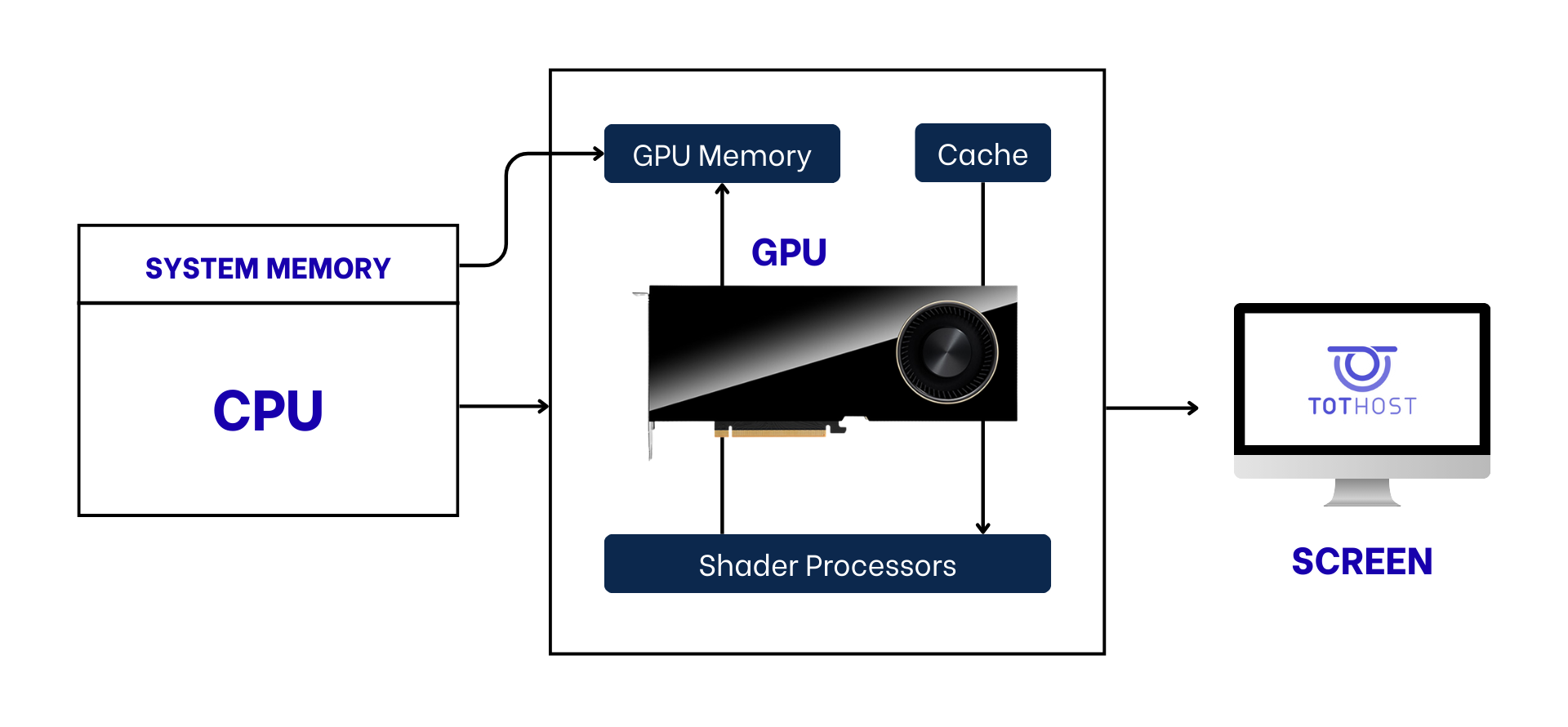

1.2. GPU 的主要组成部分 与一般仅具备 4~64 个核心的 CPU 不同,现代 GPU 采用了高并行的架构,以提升运算吞吐量与带宽效率:

CUDA 核心或流处理器:负责执行大规模并行的数学与图形计算任务。 VRAM(视频内存):GPU 的独立存储,用于保存 AI 模型数据、贴图、画面缓存及矩阵信息。显存越大,GPU 的任务处理能力越强。 Tensor 核心与 RT 核心(部分型号具备):面向 AI 运算与光线追踪的专用单元,用于加速深度学习与图形渲染。 内存总线与带宽:影响 GPU 与显存之间的数据交换速率,是衡量整体性能的重要指标。 1.3. GPU 是如何运作的?

可以通过一个简单的类比来理解 CPU 与 GPU 的差别:

CPU 像一位数学教授,专注于复杂问题的逻辑推理与顺序求解,主要负责操作系统调度与办公程序运算。

GPU 则像一支庞大的士兵部队,能在同一时间执行数十亿个小规模计算任务,具备强大的并行处理能力。

当系统需要执行诸如 3D 场景渲染 或 AI 模型矩阵运算 等任务时,GPU 会将大任务拆解为成千上万个小任务并行处理,因此在特定计算场景中,其速度可比 CPU 快上数百倍。

2. 为什么 AI 离不开 GPU? 可以这样理解:数据是燃料,而 GPU 就是驱动 AI 飞升的引擎。

根据 斯坦福大学 AI Index 与 NVIDIA 官方报告 的统计,生成式人工智能(Generative AI) 的崛起(例如 ChatGPT、Gemini)与 GPU 技术的发展密不可分。

下面是基于真实数据得出的 四大关键原因:

2.1. 并行计算架构:“蚂蚁军团”战胜“巨人” 深度学习(Deep Learning)的本质,是在同一时间执行数十亿次矩阵乘法与向量加法。

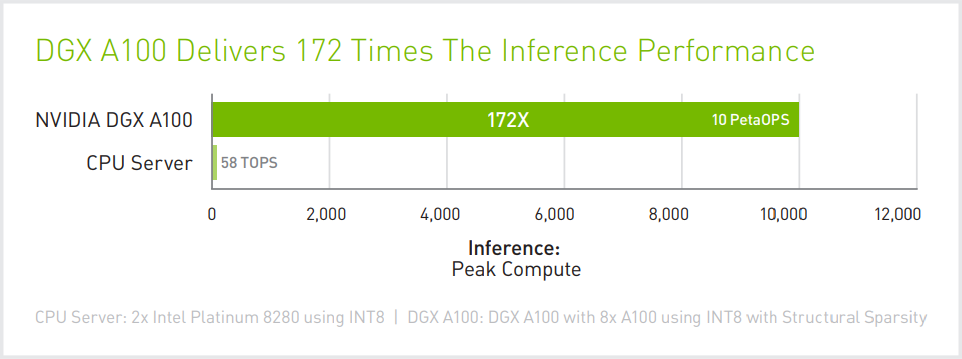

CPU(中央处理器):设计用于 串行处理(serial processing),即逐步完成复杂运算。一台高端服务器 CPU(如 Intel Xeon Platinum)通常只有 24–64 个核心。 GPU(图形处理器):天生为 并行计算(parallel processing) 而生。例如专为 AI 设计的 NVIDIA RTX 5880 Ada,拥有多达 14,080 个 CUDA 核心。 根据 NVIDIA 技术报告,一套专用 GPU 系统(如 DGX A100)在 AI 推理(Inference)任务中的处理性能,可达 双路 Intel Xeon Platinum 8280 服务器的 172 倍。

GPU 专用计算平台与顶级 CPU 服务器在 AI 处理性能上的对比(来源: NVIDIA ) 2.2. 内存带宽(Memory Bandwidth)——大数据时代的“瓶颈突破者” 在训练大型 AI 模型时,芯片的计算速度并非唯一关键,数据输入(I/O)速度 才是决定性能的核心因素——这正是 GPU 显示出压倒性优势的地方。

CPU 内存带宽: 通常在 50 GB/s – 200 GB/s 之间(取决于 DDR4/DDR5 服务器内存规格)。 GPU 内存带宽: 根据 NVIDIA 官方技术文档,NVIDIA H100 的带宽高达 3.35 TB/s(约 3,350 GB/s)。 ➡ 相比之下,GPU 的数据传输速度约为 CPU 的 67 倍,几乎完全消除了大数据训练中的“瓶颈效应”。

2.3.经济与时间效率(Cost & Time Efficiency) 许多企业误以为使用 CPU 的成本更低,但从 性能 / 价格比(Price / Performance) 来看,GPU 实际上更具经济效益。

根据 io.net(2025) 的研究,在同一 AI 训练任务中:

使用 CPU:耗时约 100 小时,成本约 408 美元。 使用 GPU:仅耗时 5 小时,成本约 164 美元。 ➡ 也就是说,使用 GPU(或 TOT GPU VPS) 不仅能让项目完成速度快 20 倍,还可节省 超过 60% 的预算。

2.4. 模型参数的指数级扩张 据 Epoch AI(与 Stanford AI Index 合作的数据研究机构) 指出,用于训练先进 AI 模型的计算需求正在以 每 5~6 个月翻倍 的速度增长。

GPT-2(2019):约 15 亿参数。 GPT-3(2020):约 1750 亿参数,仅一年增长逾百倍。 GPT-4(2023–2024):尽管 OpenAI 未公布官方数据,但研究推测模型规模已达 数万亿级参数。 → 只有 GPU 集群架构 才能在算力与扩展性上支撑这类超大规模模型的训练。

总结来说:用 CPU 来训练 AI,就像骑摩托车去搬运一千吨货物——理论上可行,但可能要花上一辈子。而 GPU 就像一列高速火车,能在短短几小时内完成同样的任务。

3. 为什么图形处理离不开 GPU?

在踏入人工智能舞台之前,GPU 一直是视觉创作行业的核心动力。

不同于普通的文档或办公处理,现代的图形渲染与影视特效制作工作流几乎全部建立在 GPU 的高并行运算架构之上。

下面根据权威基准测试(Benchmark)结果进行详细解析:

3.1. 3D 渲染性能对决 在 Blender、V-Ray 与 Cinema 4D 等主流三维软件中,渲染阶段是最“吃算力”的部分,因为系统需要计算数以百万计的光线追踪(Ray Tracing)与反射运算。

CPU 渲染: 逐块处理屏幕图像,每次只计算一个区域。 GPU 渲染: 借助数千个 CUDA 并行核心,可同时渲染整个画面像素,大幅提升效率。 根据 Blender Open Data 实测:

Intel Core i9-13900K(CPU): 得分约 520。 NVIDIA RTX 4090(GPU): 得分约 12,600。 → 总结: GPU 在渲染速度上领先约 24 倍,将原本需要数小时的渲染过程压缩至几分钟完成。

3.2. 视频剪辑:流畅处理 4K / 8K 与实时特效

对于使用 Adobe Premiere Pro 或 DaVinci Resolve 的视频编辑者而言,GPU 不仅影响导出(Export)速度,更直接决定剪辑时的流畅度(Playback)。

GPU 加速(Hardware Acceleration): 像 Lumetri Color(调色)、Gaussian Blur(高斯模糊)、Warp Stabilizer(防抖) 等高负载特效都由 GPU 直接计算。

若无 GPU 支持,时间线(Timeline)将严重卡顿甚至掉帧,无法实时预览。

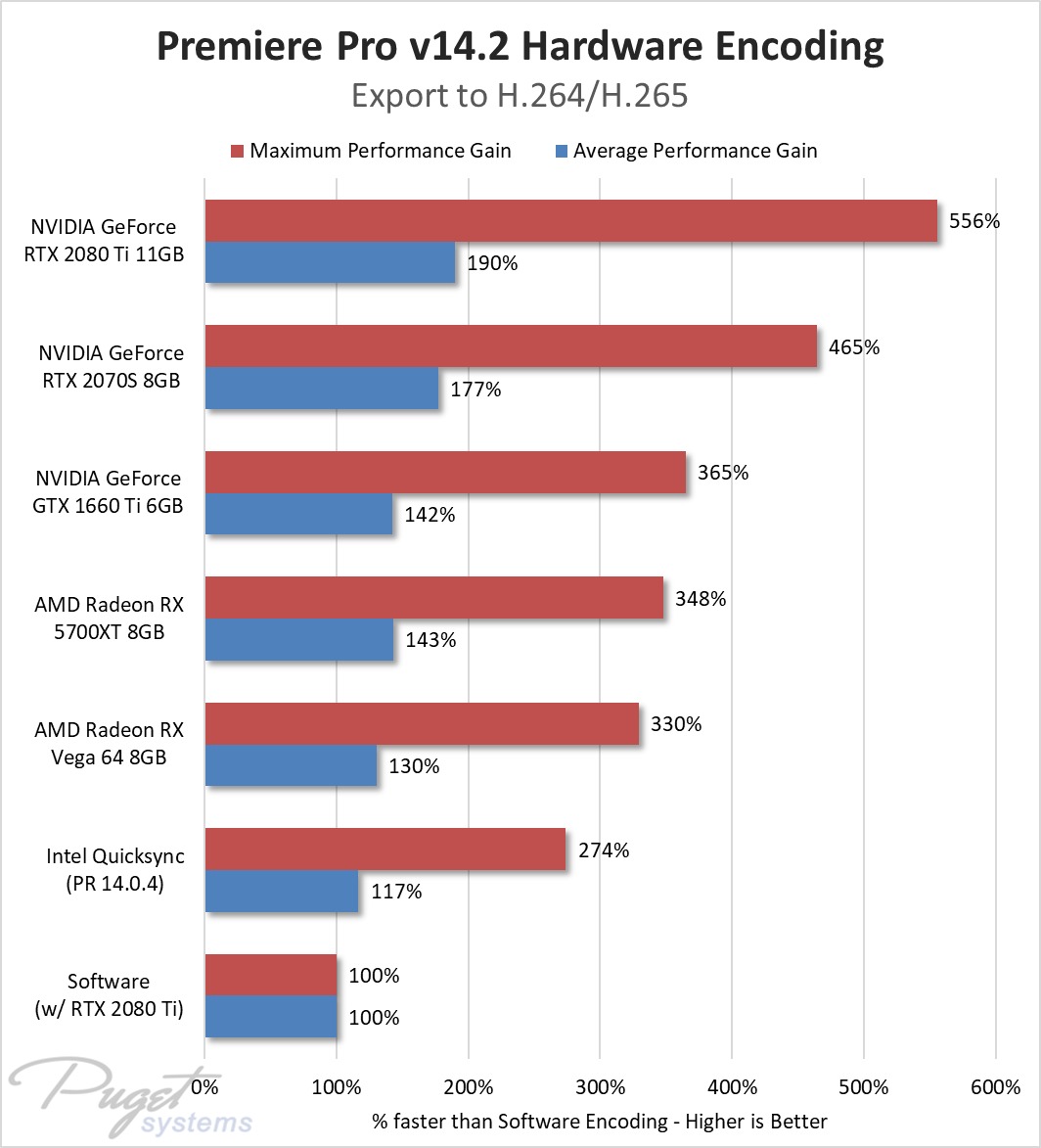

现代 GPU(如 NVIDIA 系列)内置 硬件视频编解码单元,如 NVENC 编码器,可将视频导出(H.264 / HEVC)任务从 CPU 转交给 GPU 执行,从而释放 CPU 负载、显著提升导出速度。

实测数据(来源:Puget Systems Hardware Encoding Test):

启用 Hardware Encoding(GPU 加速) 时,导出速度比 Software Encoding(CPU) 快 2~5 倍。 实际案例:一个 4K 视频项目,用 CPU 渲染需 60 分钟,使用 GPU 仅需 12~15 分钟 完成。 → 节省约 80% 渲染时间,这对需要快速交付成片的视频制作项目尤为关键。

3.3. Ray Tracing 与 DLSS:开启真实画面的新纪元 在 游戏开发 与 建筑可视化渲染 等行业中,GPU 推动了两项关键技术革新:

通过实时计算光线的反射、折射与阴影,实现接近真实物理效果的视觉表现。

仅配备 RT Cores 专用单元 的 GPU(如 RTX 系列)才能高效完成这类高强度运算。

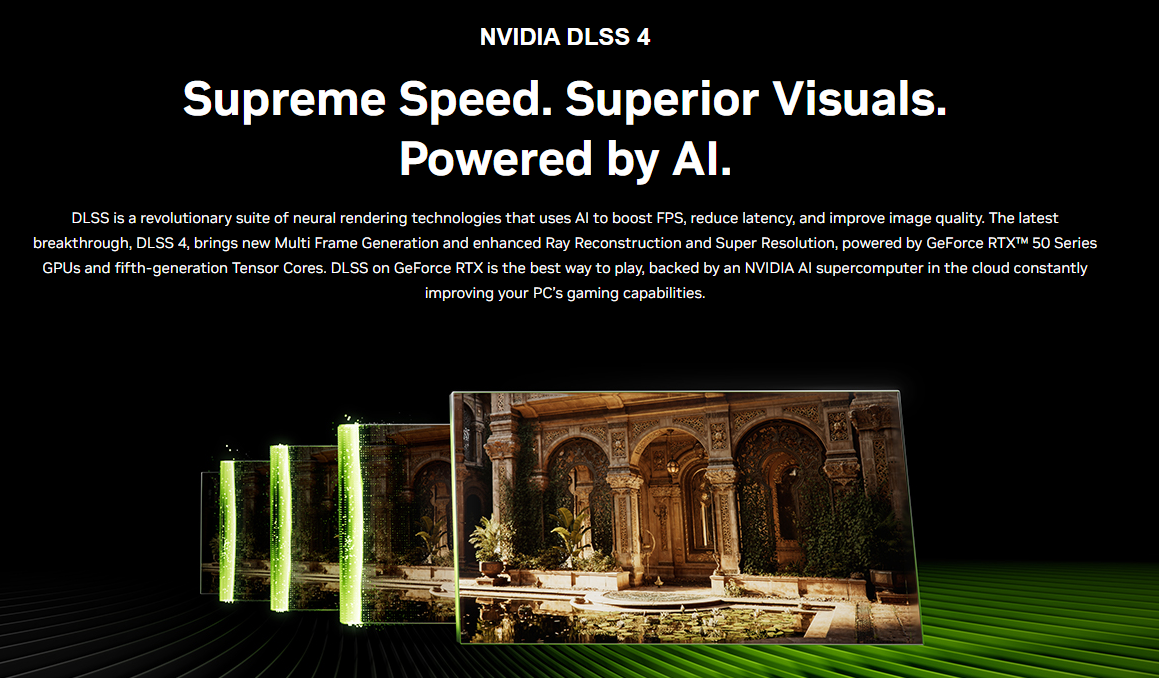

利用 GPU 内置的 AI 模型将低分辨率图像智能放大到高分辨率,实现高画质与高帧率兼得。

举例:GPU 实际渲染 1080p,但经 AI 处理后可输出 4K 清晰画面,帧率提升可达 2–3 倍(资料来源:NVIDIA)。

3.4. VRAM —— 纹理处理的高速“仓库” 不同于系统内存(RAM),GPU 的显存(VRAM) 具备极高的访问速度,其带宽可达数 TB/s(参见第 2 节)。

在专业图形工作中,VRAM 的容量决定了项目规模上限。根据 Puget Systems 的测试结果:

8GB VRAM: 适用于基础的 4K 视频剪辑与中等复杂度的 3D 设计。 12GB–16GB VRAM: 必需于 6K / 8K 视频剪辑或高精度多纹理 3D 渲染场景。 24GB VRAM 及以上(如 RTX 5880 或 A100): 用于 AI 模型训练、影视级渲染与科学仿真等超大负载任务。 总结来说:在现代图形领域中,CPU 是“指挥官”,而 GPU 才是真正的“生产机器”。

若缺少高性能 GPU,再优秀的创意流程也会陷入停滞。

4. 选择合适的 GPU:根据需求量身定制 GPU 的选择完全取决于您的使用目的。

基础与办公需求

若仅用于 Word、Excel、网页浏览或轻度 2D 图像编辑(如基础版 Photoshop),集成显卡(iGPU)或入门级独立显卡已足够满足需求。

中级需求:游戏与视频剪辑

如 NVIDIA RTX 3060、4060 等型号是主流选择,兼顾游戏性能与中等强度的视频渲染任务。

专业需求:AI 训练、渲染农场、Big Data 分析

这是对 GPU 性能要求最高的领域:

需求: 需要超大显存(24GB~80GB)以容纳庞大的 AI 模型,并具备极高的内存带宽。 挑战: 专业级 GPU(如 NVIDIA A100、H100)价格昂贵,且电力与维护成本高。 最佳方案: 选择 GPU 云服务器租用。无需高额前期投入,即可按小时或按月使用高性能 GPU 资源。 TotHost 的 TOT GPU 服务 已预装 Docker、Python 等开发环境,可让企业在数分钟内启动 AI 项目,以最优成本获得顶级算力。

5. 结论 GPU 在 AI、图形渲染与工程仿真等各类任务中都扮演着核心角色。凭借强大的并行计算能力,GPU 能将原本需要数小时的运算缩短至几分钟甚至几秒,大幅提升个人与企业的工作效率。无论你是需要快速渲染作品的设计师,还是正在训练语言模型的 AI 工程师,掌握 GPU 的算力都已成为不可或缺的前提条件。

FAQ Q1:GPU 对日常办公是否必要?

不需要。像 Word、Excel、网页浏览等任务仅依赖 CPU 即可。只有在图形设计、渲染、AI 运算、仿真或游戏等高负载场景下,GPU 才真正发挥作用。

Q2:运行 AI 或渲染需要多少显存(VRAM)?

基础 AI(如 Stable Diffusion)至少需 8–12GB VRAM;若用于渲染或更大型模型,则建议 16–48GB。

Q3:GPU 能取代 CPU 吗?

不能。GPU 适合并行计算,但无法处理系统逻辑、顺序执行等任务。CPU 与 GPU 通常配合使用,以实现最佳性能。

Q4:租用 GPU 云服务器(VPS GPU)是否需要服务器管理知识?

不一定。TotHost 技术团队 会预先配置好运行环境、驱动与必要工具,让用户开通后即可直接使用。