Hướng dẫn xem file mà không cần giải nén trên Linux

Bài viết này sẽ hướng dẫn các bạn cách xem tập tin bị nén mà không cần giải nén trong hệ điều hành Linux.

26/07/2024

Đang Tải...

Robots.txt có chức năng giúp cho trình thu thập dữ liệu của những công cụ tìm kiếm nắm được khả năng yêu cầu thu thập dữ liệu từ website của bạn. Bài viết “File Robots.txt là gì? Cách tạo tệp Robots.txt đơn giản nhất cho Website 2024” sẽ giải thích cụ thể cho bạn biết Robots.txt là gì và những thông tin xoay quanh nó.

Mục lục

Mục lục

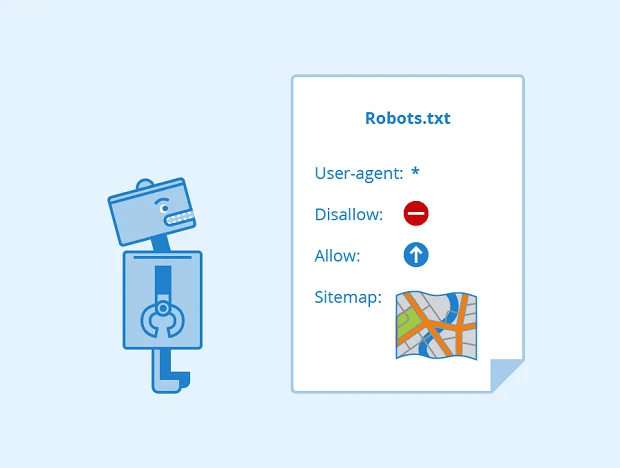

File robots.txt là một tập tin văn bản đơn giản có dạng đuôi mở rộng txt. Tệp này là một phần của Robots Exclusion Protocol (REP) bao gồm một nhóm các tiêu chuẩn Web quy định cách Robot Web (hoặc Robot của các công cụ tìm kiếm) thu thập dữ liệu trên web, truy cập, index nội dung và cung cấp nội dung đó cho người dùng.

Tệp robots.txt chủ yếu được dùng để quản lý lưu lượng truy cập của trình thu thập dữ liệu vào trang web của bạn và thường dùng để ẩn một tệp khỏi Google, tùy thuộc vào loại tệp.

Việc tạo file robots.txt cho website của mình giúp bạn kiểm soát được việc các bot của công cụ tìm kiếm ví dụ như Google thu thập thông tin trong các khu vực nhất định tại trang web. Tuy nhiên, khi tạo file bạn cần hết sức chú tâm vì nếu sai chỉ thị, các bot của Google có thể không thực hiện index cho website của bạn.

Phương thức hoạt động của file robots.txt diễn ra như sau:

Quá trình crawl dữ liệu này còn được biết đến với tên khác là “Spidering”.

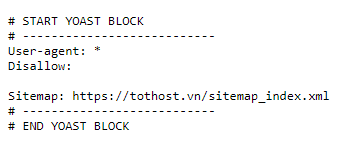

Tệp bắt đầu với dòng tiêu đề “User-agent: “, theo sau là tên của trình thu thập dữ liệu mà bạn muốn ngăn truy cập các trang web của mình. Sau đó, tệp có thể chứa một số dòng “Disallow: “, theo sau là URL của trang web mà bạn muốn ngăn bot truy cập.

Ví dụ: nếu bạn muốn ngăn Googlebot truy cập trang web “/secret-page.html”, bạn có thể thêm dòng sau vào tệp robots.txt của mình:

User-agent: Googlebot

Disallow: /secret-page.html

Bạn cũng có thể sử dụng tệp robots.txt để chỉ định các trang web mà bạn muốn trình thu thập dữ liệu ưu tiên truy cập. Để thực hiện việc này, hãy sử dụng cú pháp “Allow: “. Ví dụ: nếu bạn muốn Googlebot ưu tiên truy cập trang web “/home.html”, bạn có thể thêm dòng sau vào tệp robots.txt của mình:

User-agent: Googlebot

Allow: /home.html

Sitemap là một tệp XML chứa thông tin về cấu trúc và liên kết của trang web để giúp các công cụ tìm kiếm hiểu rõ hơn về nội dung của trang web. Khi robot tìm thấy lệnh Sitemap trong robots.txt, nó sẽ truy cập vào tệp sitemap.xml để xem thông tin về cấu trúc trang web và các liên kết liên quan.

Ví dụ, nếu bạn có một tệp sitemap.xml nằm ở đường dẫn “http://www.example.com/sitemap.xml”, bạn có thể thêm sitemap vào tệp robots.txt như sau:

Sitemap: http://www.example.com/sitemap.xml

Việc cung cấp tệp sitemap.xml trong tệp robots.txt giúp công cụ tìm kiếm như Googlebot hoặc Bingbot tìm thấy và khám phá nhanh chóng các trang trong trang web của bạn, đảm bảo rằng không có trang quan trọng bị bỏ sót trong quá trình thu thập thông tin.

Lệnh crawl-delay trong robots.txt là một chỉ thị cho bot của công cụ tìm kiếm đợi một khoảng thời gian nhất định trước khi thu thập dữ liệu một trang web. Điều này có thể hữu ích nếu bạn có một trang web lớn với nhiều trang và bạn muốn đảm bảo rằng trình thu thập dữ liệu không tải quá nhiều tài nguyên trên máy chủ của bạn.

Cấu trúc của lệnh crawl-delay là:

crawl-delay: <number>

Trong đó <number> là số giây mà trình thu thập dữ liệu nên đợi trước khi thu thập dữ liệu trang tiếp theo. Ví dụ, với lệnh “crawl-delay: 10” sẽ khiến trình thu thập dữ liệu đợi 10 giây trước khi thu thập dữ liệu trang tiếp theo.

Việc tạo file robots.txt đem lại nhiều lợi ích cho website của bạn như:

Bên cạnh đó robots.txt cũng còn một số hạn chế nhất định:

Một cách là sử dụng trình duyệt web của bạn. Để thực hiện việc này, hãy nhập URL của trang web vào thanh địa chỉ của trình duyệt web của bạn và nhấn Enter. Sau đó, hãy nhập “/robots.txt” vào thanh địa chỉ của trình duyệt web của bạn và nhấn Enter. Nếu tệp robots.txt tồn tại, trình duyệt web của bạn sẽ hiển thị nội dung của nó.

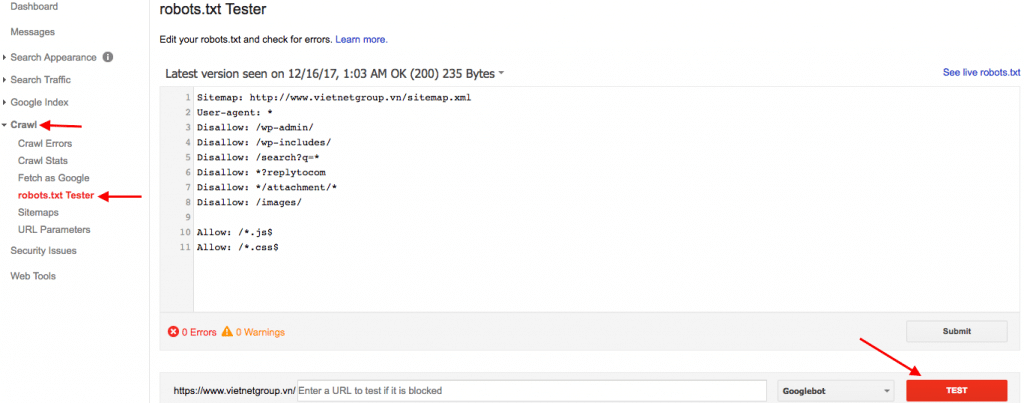

Một cách khác để xem website đã có tệp robots.txt hay chưa là sử dụng Trình kiểm tra robots.txt. Với trình duyệt Google, bạn có thể sử dụng Trình kiểm tra robots.txt trực tuyến. Điều kiện để sử dụng công cụ trực tuyến này là bạn phải liên kết website của mình với Google Search Console.

Tại mục Crawl, nhấn vào robots.txt Tester và chọn nút TEST.

Để tạo file robots.txt WordPress, bạn có thể thực hiện theo các bước sau:

Hi vọng bài viết đã được cung cấp những kiến thức đầy đủ về loại file vô cùng quan trọng với các website. Mong rằng với những thông tin đã được đưa ra sẽ giúp bạn hiểu được tầm quan trọng của nó và tối ưu hóa được chất lượng của website của chính mình. Đọc thêm các bài viết liên quan:

Domain là gì? Các bước đăng ký tên miền đơn giản 2023

Tên miền .io là gì? Lí do bạn nên sử dụng (2023)

Tên miền Việt Nam và Quốc Tế: Đâu là sự lựa chọn phù hợp nhất cho bạn?